A estas alturas del juego damos por supuesto que todos sabemos que es y para que sirve un archivo robots.txt, y si todavía no lo sabemos es fácil de entender, este es un archivo en texto plano que ponemos en la raíz de nuestro servidor y con el cual podemos “controlar” a todos los buscadores.

Pero la cuestión no es saber que es ni para que sirve si no saber configurar lo correctamente y es eso lo que intentaremos explicar hoy aquí.

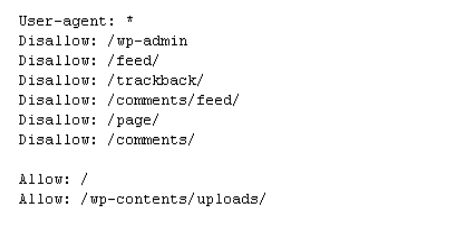

En principio el formato básico de un archivo robots.txt es el siguiente:

User-agent: *

Allow: /

Donde la primera linea indica con el símbolo “*” que nos estamos dirigiendo a todos los robots que entren en nuestra pagina, y la segunda linea “Allow: /” les esta diciendo a todos estos robots que nuestro deseo es que puedan entrar e indexar todas las paginas de nuestro sitio web.

Pero muchas veces tenemos en nuestros sitios carpetas o archivos que no nos interesa que sean indexados ya que no aportan ningún beneficio a la pagina, carpetas como script o mensajes guardados que en realidad no son de relevancia para nuestros usuarios, en tal caso podemos decirle a los robots que algunas de nuestras carpetas no deben ser indexadas, en realidad esto aunque lo parezca no es un trabajo muy tedioso para ello utilizaremos el siguiente formato.

User-agent: *

Disallow: /js/

Disallow: /cgi/

En este ejemplo le estamos diciendo en la primera linea que nos dirigimos a todos los robots que entren en la pagina y en las otras dos lineas estamos excluyendo de la indexacion 2 carpetas, el comando “Disallow” le dicen al robot que no indexe la pagina, archivo o carpeta que le damos a continuación, siempre debemos utilizar una linea con un comando “Disallow” para cada carpeta o archivo diferente que queramos bloquear.

Pero también es posible que nos encontremos en el caso de que solo nos interese bloquear un robot en concreto por cualquier motivo, esto también podemos hacerlo con el siguiente formato:

User-agent: Slurp

Disallow: /js/

User -agent: *

Allow: /

En este ejemplo nos dirigimos en la linea 1 al robot de Yahoo (Slurp) y le decimos en la linea 2 que no indexe la carpeta js, en la linea 3 nos dirigimos a todos los robots y le decimos que indexen toda la pagina.

Fijaros que primeros nos dirigimos al robot en particular y después al resto ya que los robots leen de arriba hacia abajo y acatan las ordenes del archivo robots.txt según las van encontrando, por tanto si tenemos que bloquear diferentes carpetas para diferentes robots siempre nos dirigiremos primero a cada robot en particular y después al resto de robots en general quedando una configuración como esta.

User-agent: Slurp

Disallow: /js/

User-agent: Scooter

Disallow: /js/

Disallow: /img/”

User-agent: Teoma

Disallow: /

User -agent: *

Allow: /

En este ultimo ejemplo primero le decimos al robot Slurp que indexe todo nuestro sitio menos la carpeta “js”, después le decimos al robot Scooter que indexe todo menos las carpetas “js” e “img”, al robot Teoma le decimos que no indexe nada y por ultimo nos dirigimos al resto de robots y le decimos que lo indexen todo.

Existen mas ordenes algo mas avanzas para la configuración de un archivo robots.txt que todavía nos permiten ir mas allá en el control de los buscadores pero eso es para otro articulo, con estas nociones básicas ya estamos listos para configurar de forma correcta nuestro robots.txt.

0 comentarios